07

8 月

工欲善其事:我要不要买台工作站?

- By IanGoo

说真的……找我装电脑不是不可以……但是能不能告诉我你想花多少钱?主要用来干嘛?玩游戏不?要不要对付非编和视效?要不要处理千万记录级关系型数据库(大雾)。

这话,我上大学到现在,说过好多次。其实和买车很类似,最关键的就是两个要素:1、预算;2、需求。而这两者往往是挂钩的。需求超过预算太多是做大梦,而预算超出需求太多是傻多速。这两者之间的关系,有装机经验的老油条都会有一些数。比如需求就是上网文档看电影(典型的工作机或者HTPC),3000拿下。喜欢看4K电影偶尔玩玩网络游戏,5000差不多。晚上吃个鸡,8000满足。Steam定期给G胖捐钱喜欢挥舞着4K分辨率无脑全高特效追3A大作类似《显卡灰烬》、《杀出重围:显卡分裂》、《地铁2033:最后的显卡》、《毁灭显卡》还有一年一度的《显卡召唤》、《极品显卡》的骨灰玩家,就得准备五位数了。当然配出来的机器也可以满足轻度的内容生产,Premiere可以用,AfterEffects别使劲作也行,适合B站Up主。搞游戏直播,麻烦再追加几千预算因为核心不够用了……

但是,总有一类电脑会把这样的对应关系一把糊在墙上——4核8线程3.5GHz处理器+8G DDR4+256G SSD+4G显存的独立显卡,还不含显示器键盘鼠标,这种级别的电脑自己装不带显示器键盘鼠标也就是个5千的预算,但是这家无良厂商狮子大开口:1万!

究竟是谁这么黑?这背后是道德的沦丧还是人性的扭曲?

无他,这货是一台工作站。

工作站,用起来很特别嘛?

一点都不特别。

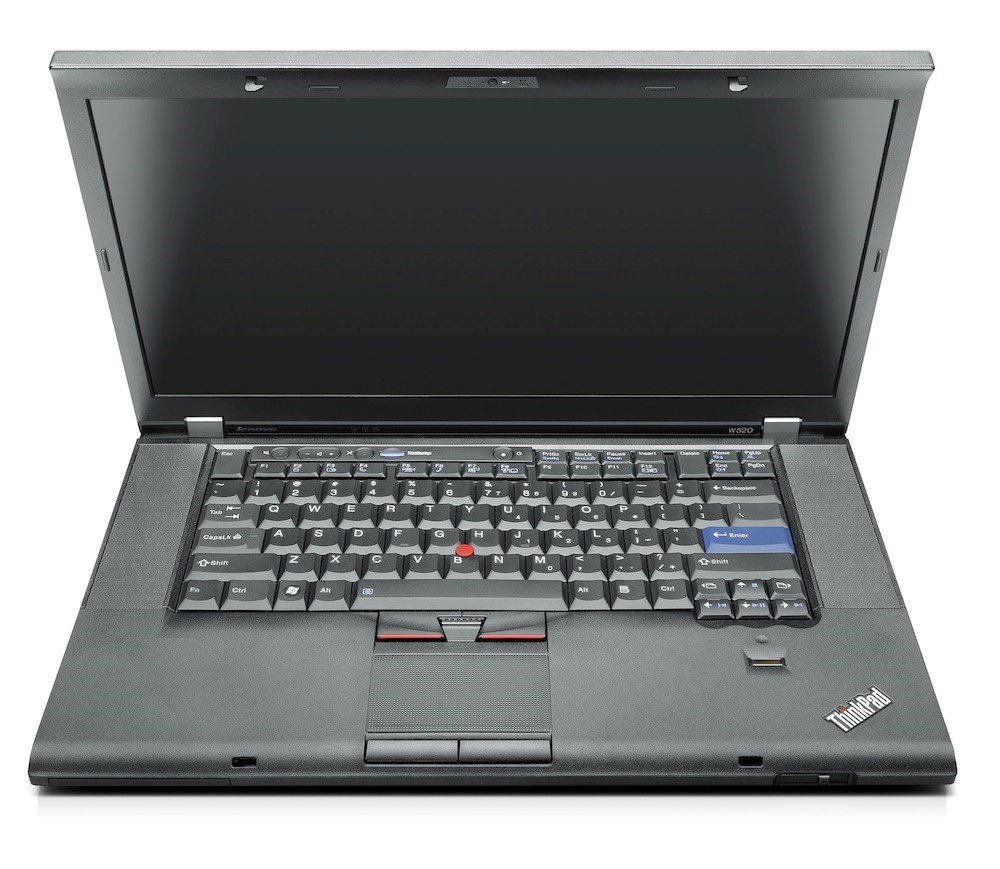

现在想想我算是被电脑重重包围的人了。卧室有一台ThinkPad,客厅接着电视平时被当成服务器霍霍的是一台英特尔NUC,书房放着自己攒的核动力大炮,到公司和一台戴尔Precision大眼瞪小眼八个小时,平时随身带一台顶配小米。 这其中有两台是比较特别的,就是被称为“工作站”的机器——公司的戴尔Precision和卧室的ThinkPad。型号分别是Precision T5610和ThinkPad W520。

但我会说,这两台基本上是我这一堆电脑当中最慢的两台了么……W520自不必说,再怎么是台厚重无比的“移动工作站”,它也只是台笔记本,加上年纪最大,尽管接受了三次升级(加装SSD、加装内存、加装光驱位硬盘托架),用起来的体验已然不及新晋的后生。而T5610,也不知道为什么竟然配发的全是HDD。21世纪都快过去20年了还有这么耿直的电脑也不容易。在跨入了SSD的大门之后,谁都会觉得HDD的速度简直是催人泪下。

后来查了一下配置,却惊觉T5610竟然最贵,W520紧随其后,实际性能表现最为强大的核动力大炮反而只是第三贵,这还是含显示器不含鼠标键盘的价格。

抢钱啊!

明明工作站不会让你羽化而登仙,也不会让你出任CEO迎娶白富美走上人生巅峰,就连干它的本职工作都不算快——同样一张2K CPU渲染,核动力大炮走起,打个盹看两集柯南,完事了;到了T5610上,同样的六核12线程处理器,得从吃午饭跑到下班;W520?移动i7和鹰翼风扇正瑟瑟发抖。当然NUC和小米是吃瓜群众,本就没指望这俩能干粗活。工作站也不是没有快的,但是要达到那种速度,受累价格后面再添个0。

当然,价格添个0的工作站,正常的主机厂Studio里也都有。CADer们让我看见你们的双手!大声告诉我,每天上班开机要几?分?钟?

我说怎么每天上班前都能看到CADer在涮茶杯、接水、泡茶、磨咖啡、翻杂志、晒太阳、撸猫,转头就看见他们的电脑十分钟过去,仍然是黑屏上一行行白字素面朝天。这个时间确实该利用起来好好摸鱼,不该扣工资。

对比一下,1.6W自己动手丰衣足食出来的核动力大炮,从按下电源到进入桌面环境,15秒钟。装着Windows 10、启用快速启动的小米从按下电源到进入桌面环境,只需4秒。这里估计得有十秒钟的差距是因为Windows 10和Windows 7的差别(Windows 7没有快速启动)。

吁……多年块垒导致这么长一段话痨级吐槽。现在舒服多了。

话说回来,工作站这种电脑物种,发明出来就是坑钱用的吗?

那当然不是了。事实上,工作站之所以成为工作站,它和普通的电脑是有一些区别的。

黎明时代

说“Workstation”之前,我们得说说现在日渐式微的“台式机”(Desktop)。我们先将移动工作站(Mobile Workstation)与笔记本(Laptop)放在一边,说桌面式的工作站。

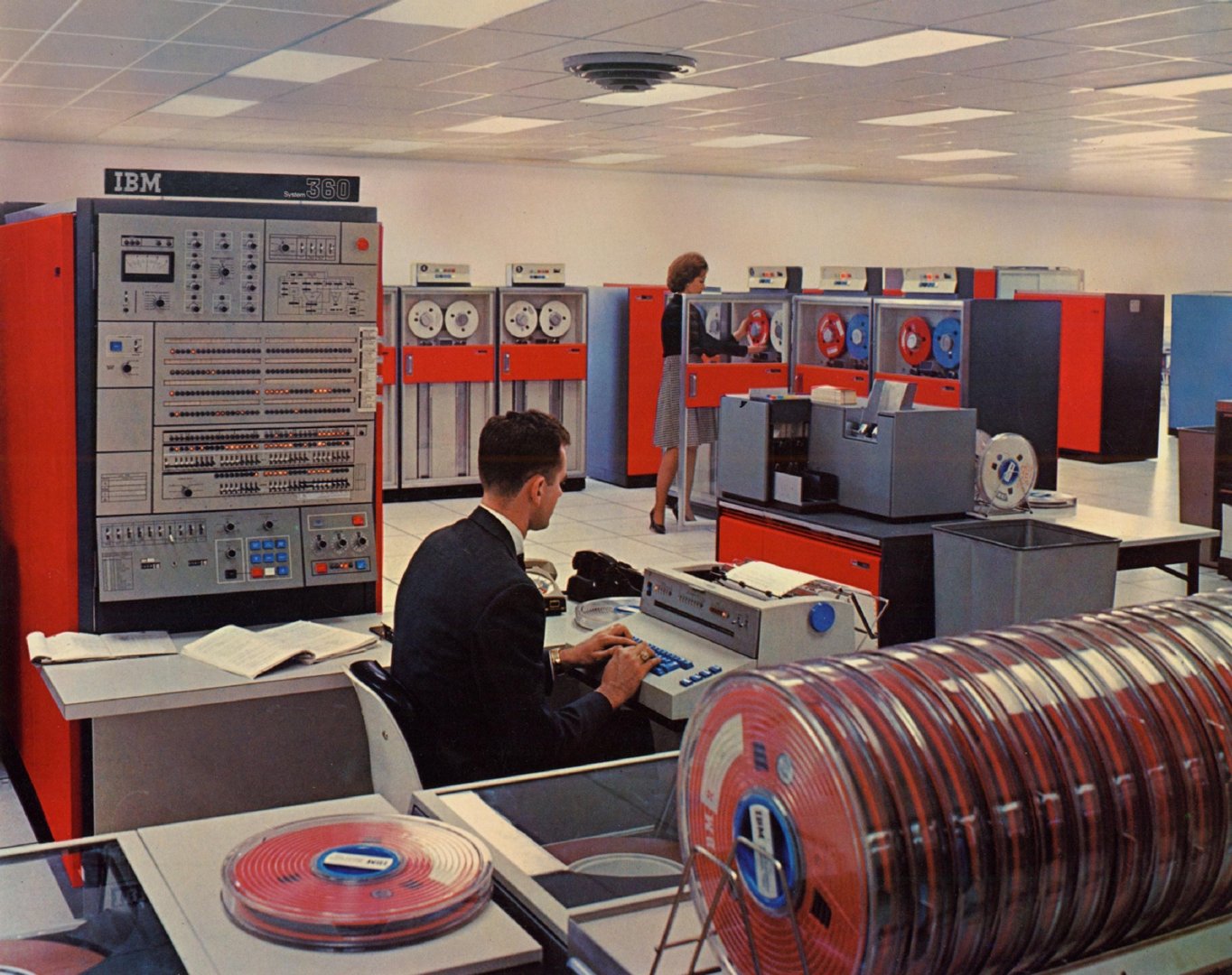

这年头用台式机的基本都是老司机了,普通用户更乐意抱个笔记本找个舒舒服服的沙发把自己团起来,轻度用户连笔记本都懒得拿,iPad多轻松。人嘛,总是想着怎么舒服怎么来的。相比正襟危坐在书房工作台前,猫在沙发或者趴在床上更省心。但是这样的场面,在60年前是不可想象的。 众所周知,早期的电脑那是极其庞大的。且不说电脑的老祖宗、占好几个屋子的ENIAC,就算是到了后来掀起电子计算机“小型化”的IBM 360,尺寸也得是这样的:

图里黑色西服男操作的是终端(Terminal),也是这台计算机的输入设备,他身后那个看起来神似配电板的东西,就是主机了。至于远处的Lady,她正在处理的那一排排的是这台计算机的存储设备——用的是磁带。暂时不用挂载的磁带都摆在镜头里最近处。

就这么个“小型”计算机,依然是占满一屋子。不过和使用电子管的第一代计算机(以ENIAC为代表)和使用晶体管的第二代计算机(以IBM 7094为代表)相比,我们已经能看到将一台电脑摆在桌子上的曙光了。集成电路(IC)取代了繁杂的线缆,将电脑的体积已经缩小了不知凡几。到DEC PDP-8的时代,小型计算机已经可以勉强摆在桌子上了。虽然仍然要外挂一堆机柜。

这个曙光最终在1971年正式来临。Intel成功研制了第一块微处理器(Microprocessor)——4004。计算机进入了大规模集成电路和超大规模集成电路时代。

微处理器,以及随后整合程度更高的中央处理器(CPU)才让今天的“PC”成为可能。

而“Workstation”——老规矩,一定会比“Desktop”更早出现。事实上,被认为是第一个“Workstation”的机器是IBM 1620,时间:1960年。

为啥这么说呢?

“工作站”是这么定义的:

一种特殊的电子计算机,设计用于工程技术或者科学应用。最初的工作站指的是任何接入LAN的电子计算机。随着工作环境的变化,工作站逐渐演变为一类特殊的计算机,往往提供比同时期主流个人计算机(PC)更强大的运算性能与图形性能、更大的存储容量和更强的多任务能力。工作站常常用于可视化、大规模数据运算(如3D设计、工程模拟计算),但是外观看起来和一台普通的桌面计算机没什么区别。

是的,“工作站”这个概念,早在大型机时代就已经出现了。只是和今天工作站≈高性能计算机的认知不同,当时的“工作站”实际上更接近于一个专供个人工作使用的计算机。而IBM 1620正是这样的终端设备。

从一开始,“Workstation”这个概念就从没有和“台式计算机”扯上什么关系。因为那时候台式计算机还不存在,主流的计算机形态是“Mainframe”,大型机。就是一摆好几个屋子的那种。大型机的操作非常复杂,因此,为了让这台机器开动起来,大型机专门配备有一队操作员(Operator),用户得排队将程序(一般是卡片)交给操作员,操作员放进卡片,一顿忙活调整电路,才能开始进行计算。

这个时代的计算机系统极为原始,整个机器只相当于一颗运算器。而操作员则扮演了人肉控制器+人肉操作系统的角色。当然,想也知道这个操作系统一次只能接受一名用户的请求、运行一个程序。暂时还没排到的用户只能在“候机室”里喝茶聊天谈笑风生。

终于,在计算机日新月异的进化过程中,人肉被电子元件取代了。以Unix为代表的多用户系统,以及局域网(LAN)的出现,还有打卡程序被丢进历史垃圾桶,电脑也不那么庞然大物了,真有需要的一人一台计算设备多好,虽然在当时这是不可想象的奢侈。

这种专门供一个或者几个人使用的个人向、工作用电子计算机被称为“工作站”,它是和算力强大但是需要去排队使用的Mainframe对应的一个概念。

真正意义上奠定现代工作站基础的是70年代麻省理工开发的Lisp机。它定义了工作站的几个要求:

- 高性能

- 联网工作

- 面向单用户环境

- 拥有极为丰富的交互使用特性

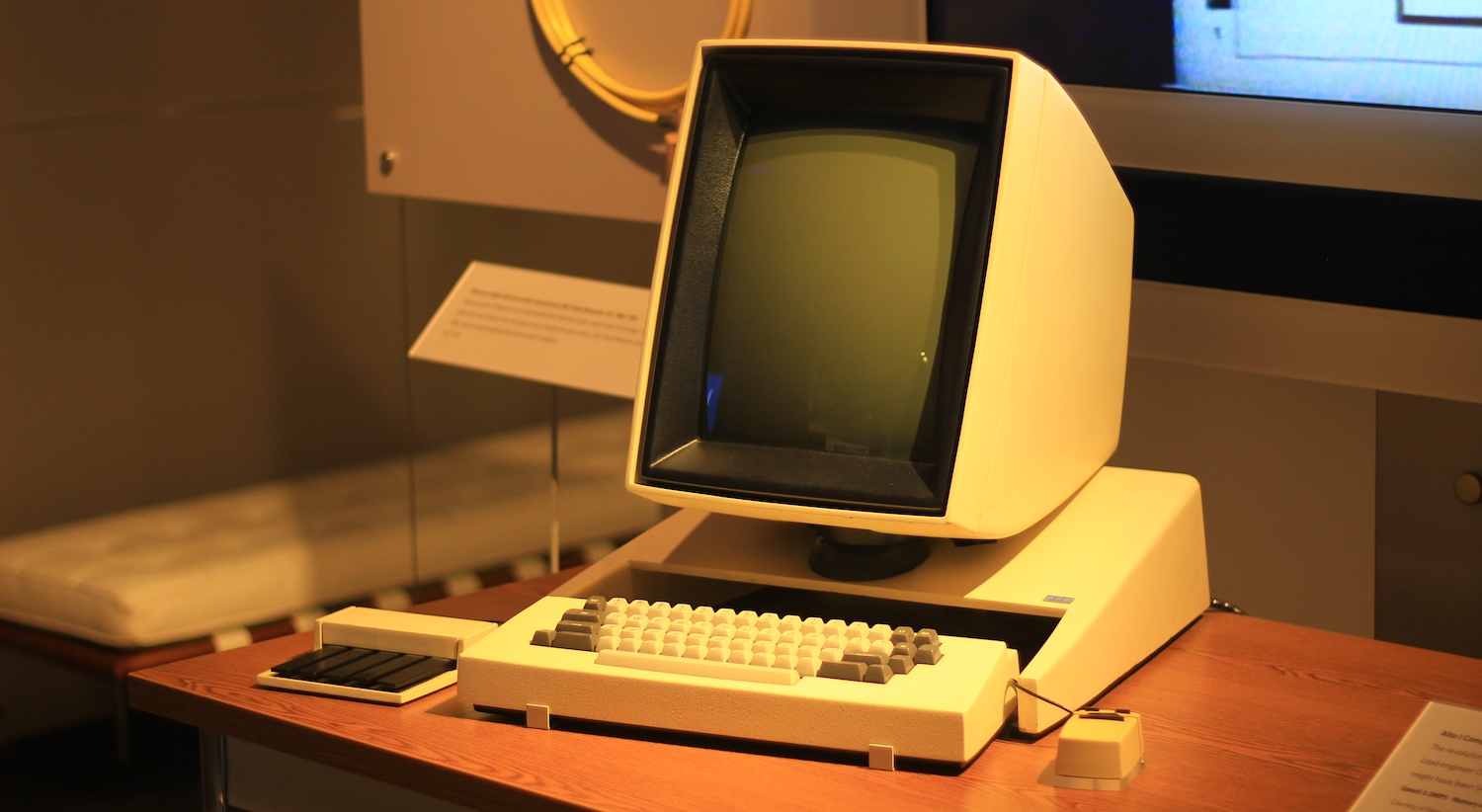

80年代,Lisp机开始商业化,Symbolics、Lisp、德州仪器和施乐相继推出了Lisp机的商业化版本。其中在1973年,施乐PARC开发的Alto更是第一个带有高分辨率图形显示的设备。

不过遗憾的是施乐并没有继续发展Alto。但是Alto那多姿多彩的图形显示和新颖的鼠标操作却让Steve Jobs大开眼界。回到Apple之后,就启动了“Lisa”项目。这个项目最终没有成功,却为Apple积累了大量的经验,最终在Macintosh上,图形用户界面(GUI)大获成功。

后来,Steve Jobs在Bill Gates面前得瑟了一把Macintosh样机,GUI的概念一下子刺激了Bill Gates,他也从施乐大举挖人,开始研发自己的GUI操作系统,最终导致和Steve Jobs矛盾激化,几乎法庭见面。然而Steve Jobs与John Sculley矛盾激化,被踢出了苹果。Sculley还给Gates签署了技术许可协议。这是一个让Jobs暴跳如雷,也在日后让Sculley后悔不已的决定。

今天占据个人计算机操作系统市场占有率超过90%的Microsoft Windows,就是在这样的一地鸡毛当中诞生的。

与此同时,在MIT的象牙塔中,一帮人也开发了一套图形界面框架——X Window Systems。时至今日,X已经发展到了第11个版本(X11),已经成为类Unix系统GUI的行业标准。Gnome和KDE都是在X11的基础上构建起来的。

工作站的富交互拼图完成了。

微处理器、局域网、小型化、富交互特性,所有元素齐备,工作站在80年代迎来了大发展。

黄金时代

80年代早期,最成功的微处理器是摩托罗拉68000,在这款处理器的基础上,Apollo、Sun Microsystems均推出了安装了Unix系统的工作站产品。

而另一方面,图形用途的工作站也开始出现——这就是今天CADer们一切苦难的根源(大雾)。

图形工作站可以追溯到DARPA(国防高级计划研究所,隶属于五角大楼)的VLSI计划。VLSI是“Very Large Scale Integration”的缩写,即“超大规模集成”的意思。VLSI计划的首要目的就是提升微处理器芯片的运算能力。在当时,微处理器当中最多只能封装几百个晶体管。对于更多的晶体管带来的设计复杂度的增加,设计师无能为力。这就造成了微处理器性能的瓶颈。 项目开始是在70年代晚期,主脑是加州理工教授Carver Mead和施乐PARC的程序员Lynn Conway。但是,随着VLSI计划的进行,越来越多的个人和机构被拉到了这个计划当中,斯坦福大学的地理信息引擎(GEOS)计划、北卡州大学的Pixel-Planes计划成了VLSI计划的试验场,这两个计划的内容就是使用桌面级微处理器芯片来进行图形运算。斯坦福的GEOS计划促成了一套网络化CAD系统,被称为Stanford University Network,简称“SUN”。这一设计后来成功商用化,所成立的公司名称就叫“Sun Microsystems”。

Sun Microsystems后来成长为业界举足轻重的计算机系统与系统软件公司,它对世界的贡献极为巨大:Java、Solaris操作系统、ZFS文件系统、NFS网络文件系统,以及SPARC——以及SPARC背后那至今都在人们看不见的地方用计算的力量撼动世界的优秀设计——RISC。

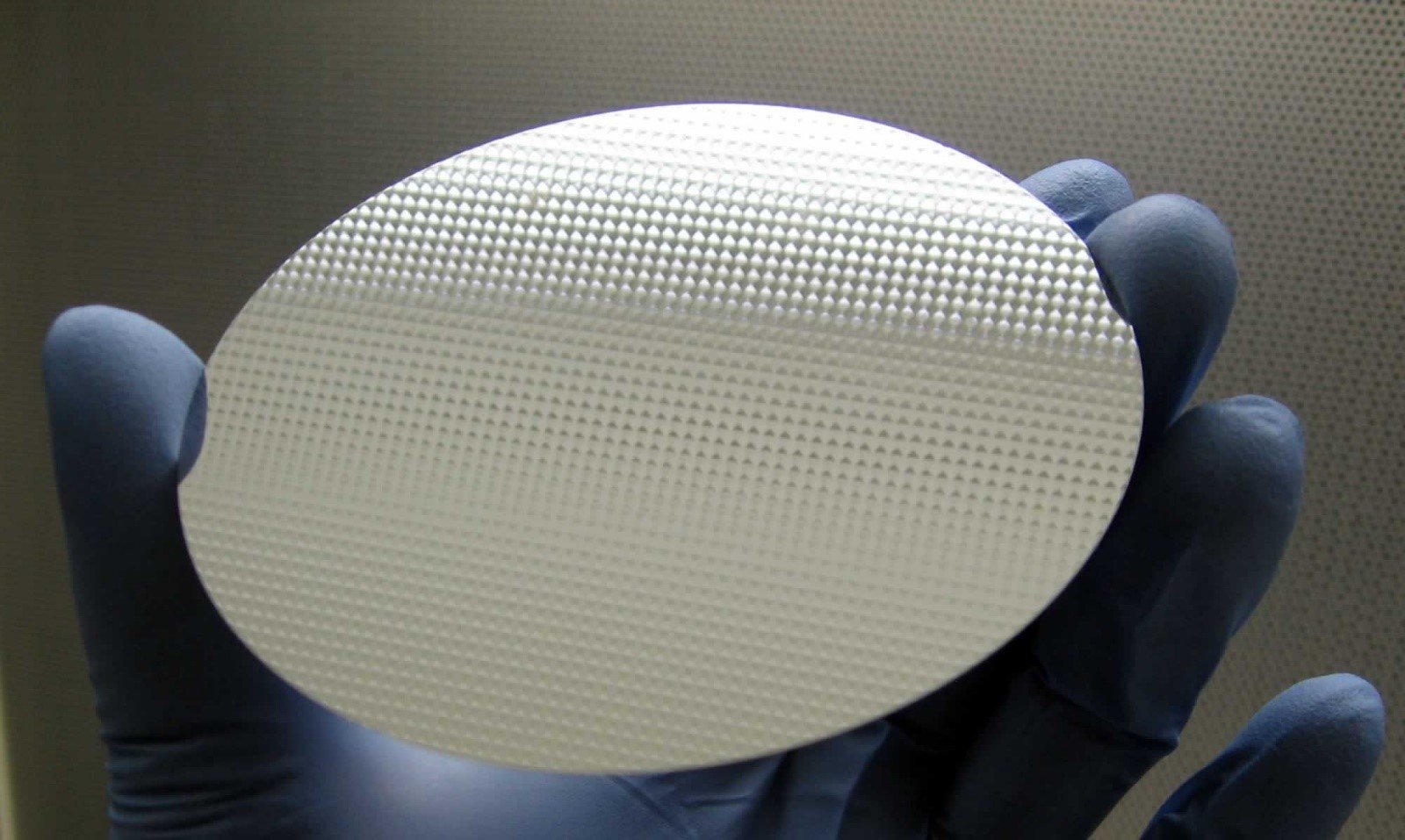

只是和很多曾经伟大的公司一样,Sun已经成为了历史。现在,Sun的全部资产都被甲骨文(Oracle)收购。 在芯片的制造方面,VLSI计划还产生了一种产物——晶圆。今天,所有的处理器制造额第一步都从晶圆开始。

晶圆的主要成分是纯度高达99.999999999%的硅,称为电子级硅。在硅的基础上使用光刻机进行蚀刻,加工出极为精细的电路,这就是处理器的心脏。而一大片晶圆可以加工出很多个芯片,这在极大程度上降低了处理器的制造成本。

80年代个人电脑(PC)与工作站的大发展,就是构建在RISC和低成本处理器的基础之上。当然,VLSI计划的成果远不止于这两个。为了统合多个机构的研发力量,加州大学伯克利分校在VLSI的资助下编写了一份Unix的实现,这份操作系统被称为Berkeley Software Distribution。人们取其缩写,叫BSD。BSD同样是影响极为深远但是却又同样不为人所知的一个操作系统。早期的工作站几乎全数使用BSD系统,今天,BSD仍然在继续发展之中,并且有了多种不同的分支,如OpenBSD、FreeBSD、NetBSD和DragonFlyBSD等。而今天的macOS,其基础也是BSD。

除了Sun,VLSI计划当中还产生了另外两个重要的工作站制造企业——Apollo和SGI。Apollo成立于1980年,1989年被HP收购,它和Sun都专注于联网数据处理型的工作站,而SGI——Silicon Graphics Inc,则是独树一帜地打出了“图形工作站”(Graphical Workstation)的概念。 在《参数化设计管窥》一文中,我们介绍了“计算机图形学之父”Ivan Sutherland。

Sutherland在离开DARPA之后创建的公司Evans & Sutherland里有一个叫Jim Clark的。不过说来也是无奈,这个世界上还有另一个知名度更高的Jim Clark——英国F1车手、两届F1世界冠军James Clark,也被称为Jim Clark。所以提起这位硅谷企业家的时候只能把Middle Name给带上,Jim H. Clark。

Jim H Clark同时也是斯坦福大学的博士,而他的导师也是Ivan Sutherland。他的毕业论文,估计会让CADer们虎躯一震——《自由B样条曲面的3D设计》。

Jim H Clark同时也是斯坦福的GEOS计划当中的成员。在GEOS计划当中,他参与开发了Geometry Engine。这是最早的专用图形加速硬件。Geometry Engine的作用就是在电脑当中生成详细的地形3D模型。

1982年.Jim H Clark与几个斯坦福的毕业生一起创建了Silicon Graphics Inc——SGI就此诞生。有Ivan Sutherland打下的坚实基础,再加上Jim Clark和SGI诸多专家的推动,计算机图形学开始进入商用时代。工作站领域也新增了一个门类——图形工作站。

这就是VLSI计划,虽然是由军方指导出资,但是却在实际上强烈推动了民用计算的快速发展。80年代中期,万事俱备,只欠东风。日渐老旧、处理能力严重不足的摩托罗拉68000处理器终于可以退休了。而工作站领域,也迎来了一场革命。

RISC Revolution

Sun SPARC——这是世界上最早的RISC处理器之一。而摩托罗拉68000,算是CISC处理器。

对于普通消费者——乃至今天的CADer来说,主要接触到的也都是CISC处理器。RISC处理器在桌面计算领域已经离普通消费者非常遥远了(却在另一个领域前所未有地贴近普通消费者)。但是在80年代中期,Sun、Apollo和SGI三家主要的工作站厂商却纷纷抛弃了Motorola 68000,转向了全新的RISC处理器。

RISC和CISC是什么?

RISC,是Reduced Instruction Set Computer,即精简指令集计算机。而CISC则与之相反,是Complex Instruction Set Computer,即复杂指令集计算机。

这两者究竟有哪些区别?

从名字上看,可以看出来仿佛是CISC比RISC要复杂一些。确实如此。学过数电的都知道怎么用电路来实现简单的加法减法。CPU的运算速度再怎么快,实际上基本原理仍然如此——通过电路来实现计算。

这就有些类似于程序设计了,但是写代码的工具是光和硅。而众所周知,码代码除了代码本身,还有一个很重要的东西——代码背后的思想,称为“算法”。那么在设计处理器的时候,就需要考虑两个问题:

- 实现什么功能?

- 用哪些硬件电路来实现?

对于一个最简单的只能做加法的电路来说(这也算一个处理器就是性能很弱鸡就是了),第一个问题就是“要做加法”,第二个问题就是拿个三极管,一堆电阻,一堆电线来搞定。

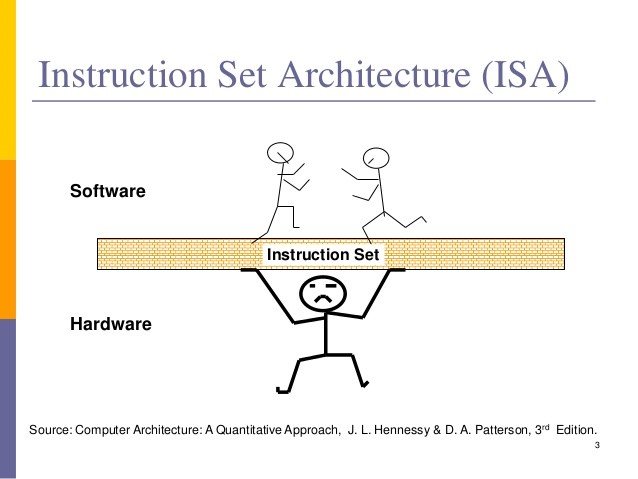

第一个问题实际上是面向程序的。它界定了“处理器可以干哪些活”。这实际上也是程序眼中计算机的样子。这种抽象意义上的计算机,被称为Instruction Set Architecture(指令集架构,ISA)。ISA当中的指令再排列组合,可以让高级程序实现更多、更复杂的功能。 而通过硬件电路所得到的ISA的实现,就是Microarchitecture(微架构)。在设计的时候,即便是针对相同的功能设计(相同的ISA),不同的厂商也会采用不同的实现,甚至在不同代际的产品,微架构也会有所不同。如我们今天说的Haswell、Skylake、Kabylake、Coffelake等等,实际上指的就是微架构。而在这些微架构的背后,指令集是不会轻易变动的。如今天的民用处理器,指令集就是X86及其64位扩展指令集X86-64。所以CPU的电路设计(微架构)日新月异,制程从微米级到了今天的14纳米级,但是由于其背后的指令集没有变,所以在软件(包括操作系统)眼中,计算机还是原来的老样子。拿最新的Core i7 8700k处理器组装一台电脑,只要能解决驱动问题,仍然可以装上20年前的Windows 98并且正常运行。

但是——ISA可不止一种。除了当今民用桌面计算领域一统天下的X86(真的一统天下了,自从苹果转投Intel以来),还有一些别的指令集架构。对于针对特定一种指令集架构设计的软件(如Windows 2000之后的Windows操作系统),换了指令集之后,软件就不认识这台计算机了,自然也就无法运行。如果要在一台IBM z大型机上安装Windows 10家庭版,也就不行了。

X86是一种极为重要的可变长度CISC指令集。CISC的设计思路就是——尽可能涵盖所有可能的使用情境。而X86具备可扩展性,今天我们买到的Core处理器,已经内置了多种极为复杂的指令集。如专用于多媒体功能的MMX指令集、MMX指令集的扩展SSE指令集、用以支持64位计算的X86-64等等。但是,由于指令集非常复杂,CISC的执行效率比较低,CISC处理器的开发周期也很长。

与CISC对应的一种就是RISC。与CISC尽可能考虑多功能的思路不一样,RISC的思路是高度专注于经常使用的几个指令,并在其基础上尽可能优化。这种做减法的思路有很多优势。最直接的就是提高了效率。也在一定程度上减轻了ISA的自然语言描述——汇编语言的运行效率。

这么说可能有些难以理解。我们就简单点说,两个电路。现在需求是要求进行加法和乘法运算。那么,电路的设计者就有两种思路:第一种,只设计一个加法电路。这样可以进行加法运算,需要进行乘法运算的时候,只需要将加法重复执行一定次数即可。这就是RISC。第二种,除了加法电路,设计者还可以在这个系统当中加入一个专用于乘法运算的乘法电路。当然,学过数电的也都知道乘法电路远比最简单的加法器要复杂得多,而且随着乘数位数(二进制)的增加,复杂度也会迅速增加,但是它的执行速度会比重复执行加法运算要高很多。这就是CISC。

RISC和CISC的优缺点互补,面向的是两个不同的市场。CISC的指令集庞大,但是CISC处理器是多面手,可以胜任各种不同的任务。这在个人计算机领域很是吃得开——毕竟谁都无法规定个人买回一台电脑只能用它来做某些特定的事情,上网、看视频、玩游戏、处理文档都有可能,甚至可以用来进行3D、视频剪辑等已经属于“商用”领域的工作。而RISC高度精简带来的优势是它可以根据特定行业的需求开发在某一方面表现极为突出的、专用程度很高的计算机,并且可以很轻松地将功耗压制在很低的水平上。其中今天最贴近普通消费者的RISC,就是ARM架构。ARM架构的设计重心是降低功耗,因此,ARM在手持设备上占据统治地位。今天几乎所有手机的SoC,均采用了ARM,不论是iPhone上的Cortex-A还是小米上的高通骁龙。Intel也曾经试图通过改进制程来优化X86处理器的功耗表现,并且推出了Intel Atom(凌动)处理器,面向移动设备市场,市面上也确实出现过采用X86架构SoC的手机,甚至在第一代iPhone设计的时候,有传言表示iPhone有可能会采用Intel的Moorestown处理器(X86),但是X86为代表的CISC虽然功能强大,但是性能/能耗始终不敌RISC阵营的ARM,另一个方面,移动设备本身的特性就决定了用户在其上的操作会受到很多限制,移动设备的用途始终不会像一台桌面计算机那样丰富多样,ARM架构已经足够应付。目前Intel已经明确表示将缩减SoC领域的投资,X86在移动平台上的尝试以铩羽而归告终。

“工作站”,自然是专用化程度很高的一类计算机。Sun和Apollo的工作站专注于数据处理与数据库,而SGI则专注于图形。显然,经过特殊优化设计的RISC更符合工作站的需求。对于SGI来说,他们选择了MIPS。 MIPS之所以得到SGI的青睐,很大程度上是因为早在80年代中期,MIPS就已经在扩展指令集当中加入了专用于3D图像处理的MIPS-3D指令集。从SGI IRIS 4D开始,SGI就切换到了MIPS处理器。

进入90年代,SGI全面切换到MIPS,并且为MIPS开发了专用于图形图像与3D处理的操作系统,称为IRIX。这套系统是在Unix System V和BSD基础上开发出来的。

MIPS时代,SGI进入全盛时期。在第二版Onyx引擎当中,SGI率先考虑了3D程序的运行库封装。通过一个统一的运行库,预留标准接口(应用程序界面,API)给程序设计师调用,这样可以极大提高3D程序的设计效率。3D程序的设计师不再需要考虑计算机的底层硬件,只需要调用正确的API,写出功能实现即可,至于具体怎么实现功能,那是API的事情。这一套API,SGI将其称为“IRIS GL”(IRIS Graphics Language)。

这是一个造福后代的事情。而更造福后代的是,1992年,SGI决定将IRIS GL整体迁移,开放源代码、邀请整个业界来共同维护这一套API,甚至以很低的价格将它授权给自己的竞争对手来使用。 这套API至今仍然构成了CG领域半壁江山坚实的基石——OpenGL。

如果对它有任何不熟悉的话,请打开自家的Playstation——它的PSGL就是在OpenGL ES的基础上扩展编写的,另外,你在Linux和Mac上玩到的任何一个游戏,背后都是OpenGL,CS的祖宗Half-Life,支持OpenGL(CS1.6仍然可选OpenGL模式)、它祖宗的祖宗Quake,背后仍然是OpenGL。

OpenGL是一个跨平台的API,由于它的开放程度极高,它支持几乎一切设别和操作系统——Windows、Linux、macOS、iOS、PSP、Playstation……不胜枚举。相比之下,OpenGL最主要的竞争对手——来自微软的DirectX,只能在Windows和XBOX上运行。 时至今日,OpenGL在SGI已经不在的情况下仍然在稳健地发展,目前,OpenGL由美国的Khronos Group,一个非盈利的行业联合会管理。目前,最新版本的OpenGL是2017年7月31日发布的4.6版本。而在OpenGL的基础上,还诞生了全新一代、跨平台、开放源代码的API,被视为微软DirectX前所未有强劲的竞争对手——Vulkan。Vulkan目前已经取得了不少游戏的支持,如DoTA 2、毁灭战士、雷神之锤、星际公民、奇点灰烬等。

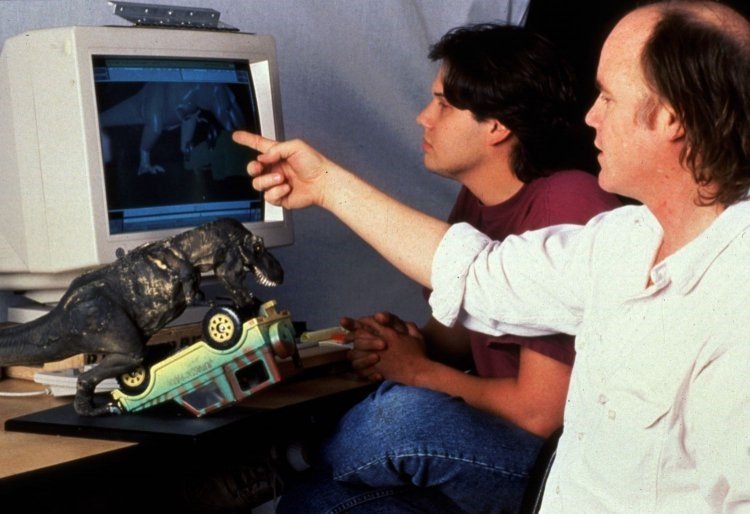

在这样的光环之下,SGI成为了3D CG行业的事实标准。恰逢电影行业开始切换到3D CG特效,SGI也就成了众多电影背后强大的助力,如侏罗纪公园、龙卷风、火星任务、黑衣人、剑鱼行动、等等。在从1995到2002的八年时间里,所有被提名为奥斯卡最佳视效的电影,均采用SGI的图形工作站制作。

80-90年代的SGI奠定了图形工作站至今都残存在人们心中的形象——专门为图形设计的RISC处理器、超强的性能、Unix操作系统、采用OpenGL API的应用程序,以及吓死人不偿命的价格。在80年代初甚至有一种说法叫“3M电脑”,专指这类高端图形工作站,所谓的“3M”,指的是达到百万像素级的显示器(1000×1000以上)、MB级别的内存、MFLOPS级别的处理器性能。而同时期刚刚订立的IBM标准PC,主流只有可怜的16KB内存、纯文本显示器,处理器的运算能力只有1KFLOPS左右,即便是加上协处理器,30KFLOPS顶天了。

然而这一切都已不复存在。在市场驱动下,PC的发展速度远远超出了人们的想象。曾经被工作站放弃的CISC、被认为只适合家用的Windows操作系统都在短短30年间就达到了一个惊人的高度。而随着娱乐需求,高分辨率显示器、强有力的GPU也纷纷跳入到PC领域。工作站与PC之间的界限开始变得微妙起来。

模糊边缘

在RISC时期,拿来一台图形工作站,用起来确实和普通的PC会有很大的差异——操作系统就不一样。为什么很多学生在初次接触Alias的时候觉得这玩意儿的操作怎么那么别扭呢?因为Alias最初是在SGI的IRIX操作系统上发布的,这个软件继承的是Unix和X Window的操作习惯。比如菜单里面点菜单项和菜单项旁边那个三角箭头是不一样的——在微软Windows的操作逻辑当中,这两个操作应该会得到相同的反馈就是展开子菜单,但是在Unix和X Window当中,这两个操作不一样。为了照顾SGI时代过来的Alias老用户,Alias | Wavefront也将这一套操作逻辑原样搬到了Windows上,至今都到了Autodesk时代了还在坑无数的学习者。

但是Alias | Wavefront迁移到Windows平台,本身也就说明了工作站历史上一个时代的行将落幕——以及一个新的时代的开启。

那就是模糊边缘时代。在这个时代,工作站与PC之间的区隔不再明显,用户大可以用工作站来玩游戏,也可以用PC来做3D,到了今天,已经很少有人能够说得清楚“工作站”和“PC”之间的区别了。

并不是工作站裹足不前,而是PC的发展速度简直是突破天际。

先来看Intel。

2017年——算起来Intel被称为“牙膏厂”也得有个快两年了。但是在Intel联合创始人、第二任CEO Gordon Moore任上,Intel绝对是计算性能的积极推动者。

1965年,Gordon Moore在Electronics杂志的一篇访谈当中这么说道:

当价格不变时,集成电路上可以容纳的元器件的数目,每隔18-24个月就会增加一倍,性能也将提升一倍。

Gordon Moore

当然很不幸,Gordon Moore是活着见证自己的“摩尔定律”失效的……随着制程被推向物理的极限,集成度越来越高的芯片也会导致巨大的发热量,半导体行业不再将摩尔定律奉为圭臬,而是开始规划更多样化的发展蓝图。从另一个角度来说未必不是好事。

但是在60-90年代,Intel的一路高歌猛进却是摩尔定律最佳的注脚。

还记得Intel的第一款处理器吧?4004,采用10μm制程,集成晶体管数量为2300个,主频108KHz。最初,4004是为日本Busicom一款可编程计算器开发的。Busicom支付了6万美元,取得了4004的所有权。但是Intel看到了这种具备通用计算能力的芯片的巨大潜力,将6万美元打了回去,拿回了4004的设计所有权。这无疑是一个极为英明的决定。一年后,8008处理器的性能直接翻倍,1974年的8080处理器则成为Altair的处理器——Altair被认为是历史上首台真正意义上的个人电脑(PC)。 很多人认为PC就是今天的台式机或者笔记本,装着Windows、用着Intel或者AMD的CPU、插着DDR4内存、挂着SATA硬盘的那种。实际上,这种PC叫做“IBM Compatible PC”,IBM兼容PC。它是今天事实上的PC标准——包括Apple也不例外。IBM兼容PC标准是在1983年才提出来的,在这之前,PC还有很多种。最早期的如IBM 610、MIR、Datapoint 2200、IBM 5100等等桌面式计算机并没有形成今天的“中央处理器”的概念,用于运算的电路并没有做成一个单独的集成电路芯片。Altair 8800是历史上第一个单芯片微处理器设计的桌面式计算机,而这也打开了现代PC的命门——价格。外部采购的微处理器芯片可以有效地降低整机的制造成本,Altair 8800成了当时炙手可热的科技产品,甚至因为严重的供不应求,导致大量用户下了订单却只能踏上漫漫等待之路。

1978年,Intel推出了8086、8088处理器。而8088更是打赢了一场关键的战争——8088被选作IBM 5150的处理器。这让Intel一举成为世界500强企业。

而业界更重大的事件则是在1981年,IBM终于松口,允许Bill Gates和他的微软向其他品牌的机器单独出售MS-DOS操作系统。在此之前,微软一直作为IBM的系统软件供应商,向IBM提供PC-DOS操作系统,不过PC-DOS——以及其他很多软件,都是被IBM限制住,和相应的硬件锁死在一起的。

这一事件看起来好像没什么,实际的意义却极为重大。第一,它标志了IBM承认了兼容IBM兼容PC标准,第二,它标志了软件行业自此从半导体行业的附庸中独立出来。

1983年,PC Magazine提出了“IBM‘克隆’PC”的概念,IBM兼容PC标准这一说法,也就从此流传于世。

不过,比较恶搞的是IBM,这一“兼容PC”的定义者,今天却早已退出了PC市场。我那台ThinkPad上,已经打上了“Lenovo”的标识。

1982年以后Intel的故事,就比较为人所熟知了。从286到386、486,1993年,Intel新推出的处理器已经容纳了310万个晶体管,它本理应被叫做“586”,但是为了规避模仿者的山寨,Intel为它取了一个新的名字——Pentium。

97年Pentium II已经能够得心应手地播放视频,99年的Pentium III装载了专门用于互联网、3D影像的指令集。也留下了一个颇有历史感的名词——Tualatin,图拉丁。尤其是Tualatin Celeron,竟然可以跨一级同时跨一个代差挑战Pentium 4。如今,“图拉丁”一词总会让人想起一群用老旧硬件、发挥它们最强性能的垃圾佬。Pentium 4却令人唏嘘地成为了最后站在Intel顶级性能产品线上的绝唱。今天的Pentium已经取代了Celeron,成为了入门级CPU的代名词。

面对加强制程、堆砌更多的晶体管、不断飙升的主频,Intel最主要的竞争对手AMD则率先打响了多核心战争。

同时期的工作站,为了应对大量的数据处理任务,常采用双CPU的设计,而这种奢侈的配置在民用领域至今都不是主流。AMD采取了一种特殊的方法——在一个CPU当中集成两个核心。AMD在这么做的时候,Intel的手段则是“超线程”(Hyper-Threading)技术,也就是把一个核心当成两个核心来用。这当然水分太足,手足无措之下intel推出了Pentium D作为应对。随着多核心时代的到来,Intel也做出了变革——不再强调主频,Pentium让位于Core。今天,想要找一台单核心的电脑,恐怕是很不容易的。连手机都开始上四核、六核处理器了。CPU的核心数量在4核心停留了有段时间了,不过随着AMD最近的动作,恐怕这一均势又要被打破了。 与民用领域对应的,是Intel在商用领域迈出的重要一步。1998年,Intel在Pentium II的基础上发布了Pentium II Xeon。

这是Intel将CISC的X86架构杀入商用领域的第一步。虽然RISC在工作站上的地位仍然看似不可动摇,随着X86处理器一日千里的发展,其地位却遭受到了前所未有的威胁。2001年,“Xeon”这个名字从Pentium系列当中独立出来,正式成为独立的商用X86处理器产品线的名称,中文名“至强”。此后,每一代微架构都会衍生出对应的民用产品线(Celeron/Pentium/Core)和商用产品线(Xeon)。这两者在硬件设计上往往有不小的区别——特别是CPU接口。但是——还记得ISA吗?Xeon和民用CPU都是一样的,所以同样的Windows既可以在民用CPU组建的电脑上运行,也可以在Xeon组建的电脑上运行。

同时,以Windows NT为代表的商用Windows操作系统也日渐发展成熟。服务器和工作站也开始渐渐接纳X86架构。如今,X86 Server和Workstation已然成为市场主流。

其中也包括SGI。1999年,在最后一个IRIX操作系统发布一年后,SGI宣布切换到X86,并与Intel、Microsoft这两个X86的最大推手达成战略联盟。IRIX止步于最后一个版本6.5。此后只有小修补,而不再有新版本的发布,直到2005年,IRIX操作系统终止支持。旗下Alias | Wavefront的软件也切换至Linux和Windows NT。

这中间还有一个小小的插曲——EPIC。EPIC是“Explicitly Parallel Instruction Computing”的缩写,也就是“显式并行指令计算”。这是由Intel、HP联合开发的一种独立于CISC和RISC的全新思路,专注于大规模并行数据处理。在EPIC的概念下,Intel和HP开发了IA-64指令集,具体的产品就是Intel Itanium(安腾)处理器。SGI也在2003年推出了基于Itanium 2和纯64位Linux的Altix。但是EPIC的体系再先进,也无法与已经成为巨大规模市场的X86相抗衡,在X86扩展到64位之后更是如此。Itanium自诞生以来,存在感就很稀薄。于是终于在今年,这个曾经承载了Intel在服务器和大型机领域巨大野心的Itanium,停产了。

再来看显示设备。除了高分辨率彩色屏幕的普及,计算机进入3D时代的过程更是堪称一部波澜壮阔的史诗——多少厂商就完蛋在奔向3D时代的路上。

早期的计算机并没有“显卡”的概念。而今天,特别是发烧级的机器,显卡往往能吃掉整机预算的一半,更有各路“专业显卡”贵的要命。这又是从何说起的呢?

90年代中后期,图形处理器(GPU)开始扮演日渐重要的角色,PC正在飞奔进入3D时代,而GPU从2D进入3D这个过程,也是实实在在地刷掉了一大批曾经的“显卡霸主”,如S3、Matrox,要么关门大吉,要么已经退守到了一个极小的市场当中。同时,新兴的后来者已经上位,或者即将上位,当时3D GPU的顶级霸主,是今天永远活在很多老玩家心中的3dfx。正在奋力追赶的,则是老黄(黄仁勋)和他的nVidia,以及老何(何国源)和他的ATI。 在3DFX统治期间,PC的3D API并不像同时期的工作站那样齐整(OpenGL千秋万载一统江湖),而是有很多不同的选择,如3DFX自家的Glide、微软DirectX、PowerVR的PowerSGL、ATI的3DCIF,当然也有OpenGL。不过1999年,微软发布了DirectX 7,它可以实现硬件级的T&L,这一特性瞬间让Glide——和背后的霸主3DFX黯然失色。

所谓的T&L,指的是坐标转换与光照。这两者都是3D游戏当中最重要的概念,同时也是最消耗资源的部分。OpenGL在专业领域其实早已实现,但是民用硬件领域从未出现过这样的技术。在DX7之前,所有的坐标转换与光照运算均需要由CPU来完成,而支持硬件T&L的GPU在DX7之后则可以接手这两项任务。nVidia GeForce 256和ATI Radeon 256迅速跟进,3DFX则成为了历史。

真正站在顶端微笑的则是微软。DirectX成为了PC领域的绝对霸主。尽管从专业的眼光看,DirectX有不少地方不及OpenGL,如对硬件的直接控制程度、跨平台特性,但是DirectX背后的Windows生态圈此时已经建成。就和再怎么先进的EPIC想要在商用市场上对抗已经成气候的X86-64都未能成功一样,Windows-DirectX带领着众多显卡厂商开始掀起了一轮又一轮民用级计算机的图形革命。nVidia和ATI(今天的AMD)在每次微软发布新的操作系统以及新的DirectX的时候,一定会在第一时间跟进,推出新的驱动,或者直接推新的显卡。当年面对DirectX犹豫不决,押宝高像素填充率的3DFX就死在这上面。

这就是延续至今的故事。N与A的战争仍在继续。尽管中间有一些小波折,比如nVidia Fermi因为功耗问题被玩家超频到冒烟,弄得nVidia到今天都被冠以“核武器”的戏称(知道为什么我那台叫核动力大炮了吧),虽然今天的nVidia能效非常之高。再比如自9550之后ATI/AMD一直被nVidia/Intel调戏至今。再比如某天突然冒出的那个让所有人下巴砸坏鞋的消息——啥?ATI被AMD收购了?

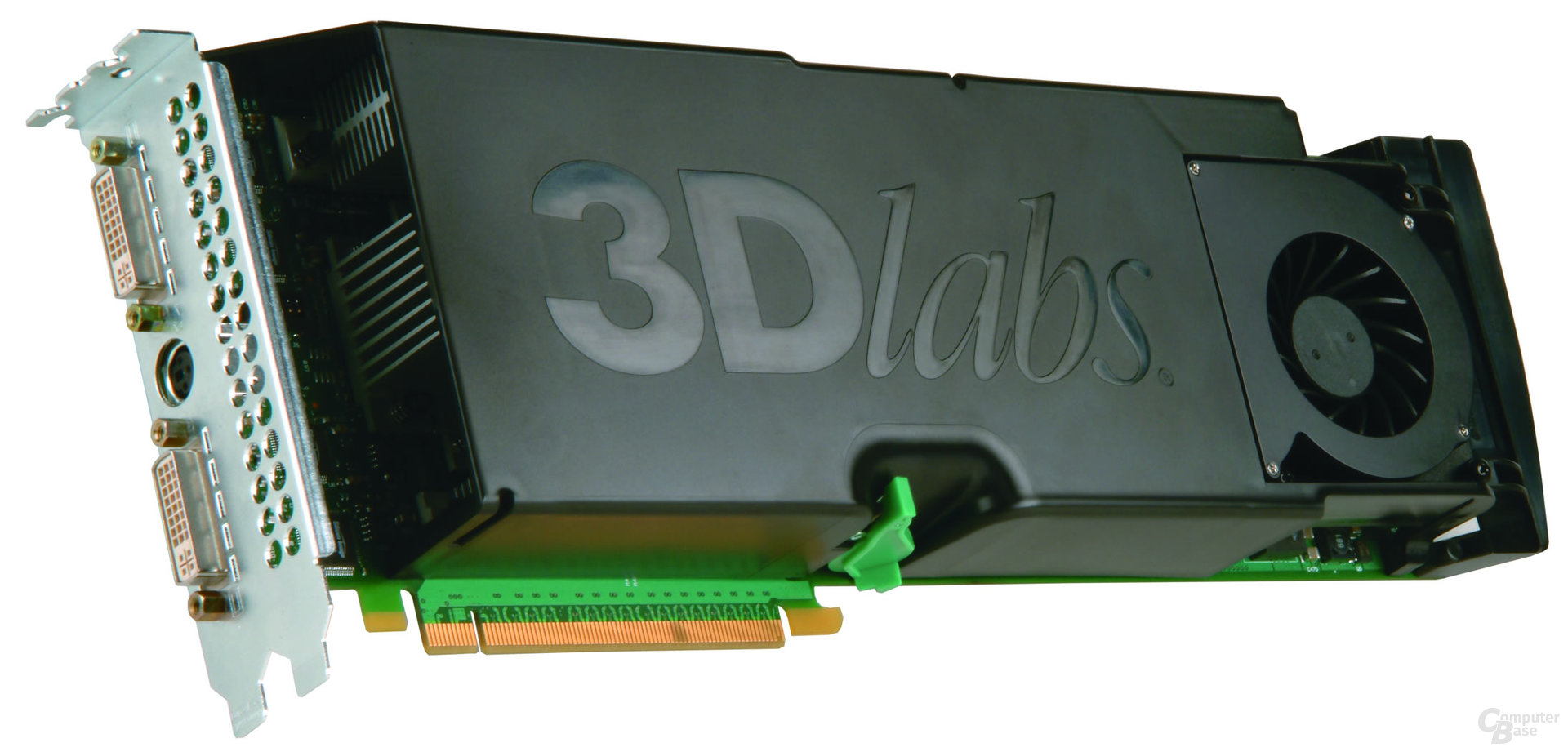

这是民用市场的故事。在商用领域,3D GPU的需求同样在飞速增长。1983年,3DLabs在英国成立,1985年从SGI处取得IRIS GL的授权,开始开发支持IRIS GL的显卡。这是一家专注于高端3D GPU的公司。他们的产品哪怕是最为入门的Permedia系列,都能够完整支持OpenGL所有的功能。

在很长的时间内,3DLabs是专业级显卡市场的唯一选择。而它也仅支持唯一的API——OpenGL。DirectX?实在是懒得碰。

尽管3DLabs具有高度完善的产品线(Permedia低端显卡、Oxygen中端显卡、Wildcat旗舰级显卡),和极为出色的性能,但是老黄的野心却并未止步于民用领域。

2004年,nVidia发布第一块专业显卡——Quadro FX330,采用NV35核心——就是GeForce PCX 5300同款。nVidia此举也奠定了日后Quadro的基调——Quadro实际上和同架构的GeForce在硬件上一样,不过在驱动和固件层面上加以限制,在GeForce上屏蔽了一些特定的功能,如高性能抗锯齿、双面光照等。

ATI涉足专业显卡的历史则比nVidia早得多。早在95年的时候,就已经推出了FireGL专业显卡。但是,它采用的GPU却是来自3DLabs的GLINT 300SX。面对产品线极为齐全的3DLabs自然不构成任何威胁。2001年以后,ATI Fire GL 8700起,ATI便采用自家的GPU来制造专业显卡。

对于这两个来自民用领域的外来竞争对手,3DLabs并没有太上心。但是很快,它就发觉nVidia和ATI虽然缺乏专业显卡的设计经验,却肥得吓人。而且,显卡能做到DirectX和OpenGL通吃,在Windows上兼容性很好。而伴随着Windows和X86系统的迅速增长,3DLabs,最后还是倒了。 在3DLabs倒下之前,这家行业巨头放出了一块超越时代想象力的惊人产品——Wildcat Realism 800,这时候3DLabs终于意识到需要考虑Windows。不过,已经太晚了。毕竟,这已经是2005年了。

这块体型巨大、性能也堪称专业显卡巅峰的产品,从显存容量、到显存总线宽度、到像素通道数量都是当时nVidia的专业显卡旗舰Quadro FX4000的双倍还多,更令人难以置信的是,在这一块显卡上,3DLabs在其中安排了3个处理器!其中一块相当于协调员,称为VSU,负责分析画面,然后将渲染负载分配给具体执行的两个运算单元(VPU)当中去。在这样巨大的压力下,nVidia只能通过另一种方法——SLI来扩展GPU的处理能力。但是代价就是需要在机箱里多插一块显卡,这成本自然也就更高了。不过所幸的是,nVidia这次没有将SLI变成商用专属的功能,而是下放到了GeForce系列当中。

在很多年以后,nVidia才拿出了多GPU解决方案——GeForce GTX Titan Z。

在放出这只巨猫之后的4年,3DLabs被Creative收购,其研发范围也从立于图形处理器顶端的旗舰级专业显卡转移到了低功耗多用途GPGPU。

目前的专业显卡领域,90%的市场份额为nVidia Quadro所把持,与GeForce系列相比,尽管GPU微架构一样,但是由于Quadro支持全部OpenGL库,仍然有不可替代的地位。对OpenGL的全面支持是GeForce系列做不到的。

除非……连专业软件都不再依赖OpenGL。

最后的界限

就拿我手头用的两台电脑的配置来看看,究竟工作站和PC到今天还有哪些区别?

| 项目 | DELL Precision T5610 | 我自己配的PC |

| 处理器 | Intel Xeon E5-2637 V4 3.5GHz,4核8线程 | Intel Core i7 6850K 4.0GHz,6核12线程 |

| RAM | 16GB DDR3-1866 ECC | 16GB DDR4-3200 |

| 显卡 | nVidia Quadro P4000 | nVidia GeForce GTX1080 |

| 存储 | 500GB SATA HDD | 512GB M.2 NVMe SSD 256GB SATA SSD 2TB SATA HDD |

基本的大件就是这些。我们不妨倒回去看看当年“工作站”是怎么定义的。尤其是“3M电脑”那段,再回来接着看。

第一,处理性能。同为6核12线程,6800K的主频比E5-2630 v2高得多。无怪渲染的时候效率高太多。I7上还压了个水冷。

再看存储器。从容量到频率,都是核动力大炮完胜——等等……ECC是个啥?过会儿再说。

再看显示性能,K4000拥有192bit显存位宽,3GB显存,流处理数量768个。

而GTX1080作为当年的旗舰,则是256bit显存位宽、8GB显存、2560个流处理器。同样,上头压了个水冷。

显示器,早在很多年前,百万像素级就早已实现。现在稍微讲究点的都纷纷上4K显示器了。这块显示器实际上已经算是很不相称地寒酸了。相比之下,K4000竟然并不能带动4K显示,最大只能支持到2560×1600的分辨率。

“高速网络连接”?算了吧,网卡连型号都一样,都是千兆级网卡。至于存储……真的不怎么想多说什么。虽然我个人认为往一台电脑里塞四块硬盘的确很二(别笑,W520一台笔记本里都有三块硬盘),但是这年头一块机械硬盘打天下的更奇葩。

总体上看,核动力大炮的性能已经是将T5610碾得连渣都不剩。但为什么“工作站”仍然要作为单独的商用产品线拿出来说事(而且还卖得那么贵)呢?

其实,这两者之间的区别还是有的。

其中最大的一个区别就是稳定性与容错性能。而这就是前面提到的那个“ECC”的意义。

今天的商用产品线未必能在性能上对抗民用产品,但是——其实,用于商用,性能未必是第一位的。真正要在第一位考虑的是稳定性。ECC就是考虑到了这一要求而出现的技术。

ECC是“Error Correcting Code”即错误校验码的缩写。这是一种可以检查、发现并纠正错误数据的技术。最原始的检错机制是Parity(奇偶校验),这是在ECC出现之前,容错内存当中最常见的一种校验方式。奇偶校验的原理就是在内存当中,每一个字节(8个bit)增加一位校验位。在送出数据前,先将8个bit加起来,若为奇数则在校验位中写入0,偶数则写入1。CPU获取数据后,将再次进行一次校验,如果奇偶校验符合,那么就直接拿来处理,如果不符合,就会尝试进行数据的修复。但是奇偶校验存在一个问题——每8个bit都需要一个校验位,这会浪费大量的存储空间用于保存校验位。

ECC改进了算法——当然,ECC有多种不同的算法,不过,它们都能够保证校验数据量增加一倍的时候才需要增加一个校验位。8bit需要1个校验位,16bit需要两个,32bit需要3个,64bit也只需要4个,如果是奇偶校验的话,64bit就得需要8个校验位才行了。 但是这毕竟还是会多出不少数据,因此,在ECC内存上,往往需要多贴颗粒。这从外观上就能分辨出来。

当然,如果你买到的是那种外观贼拉风、有RGB呼吸灯和铝合金散热鳍片的内存,可能是看不到颗粒的。不过放心,如此Fancy内存条一定是民用级产品,一般是不带ECC的。

但是这并不意味着买了ECC内存,就能够保证数据绝对正确——首先,ECC只能保证将数据错误压在一个很低的概率,而不是将出错的概率降到0,其次,ECC还需要CPU的支持——这倒并不是个大问题,即便是i3也是支持ECC的,最后,ECC还需要主板的支持——这就是问题了。哪怕现在的X旗舰级主板,由于它是民用产品,仍然不支持ECC,得上服务器或者工作站主板才行。换言之,ECC需要内存、主板、CPU同时支持,缺一不可。

当然,Intel鸡贼之处就在于,虽然i3支持ECC,但是i5和i7却不支持。因为到了i5这个级别,就已经和Xeon E3的市场份额产生了交叉。为了保证Xeon和i5/i7的差异化,自然民用CPU上的ECC支持是要阉一阉的。

同样的,在显卡上,除了是否支持全部OpenGL,GPU和GRAM是否支持ECC也是区分民用显卡和专业显卡的重要依据。原理类似,现在的显卡大致相当于一台用于图像处理的小型专用计算机,它能否纠正数据错误同样事关稳定性。

ECC的另一个问题就是——性能的下降。数据校验是要消耗一定的系统性能的。为什么配备了128GB ECC内存、24GB ECC GRAM显卡的那些理论上性能应该破表的工作站开个机都是一场漫长的等待,原因就是它需要校验。而且数据越大,校验的时间就越长。

那么问题来了——我需要ECC吗?

我们的身边永远都存在很多会让电脑中的数据莫名其妙出错的东西——电磁干扰、静电、震动等等,这些错误会在电脑的核心系统——CPU、内存当中积累。当积累到足以影响程序的正确运行的时候,就会导致性能下降和程序错误。ECC的作用就是在运行期间尽可能压制数据错误的产生。

但是,另一方面,RAM是易失性存储器,关机之后,内存就又干净得像一张白纸,数据全部断流。再启动的时候,又一切正常了。数据错误的积累,只在开机运行的过程当中产生。服务器经常会7×24小时不间断运行,因此需要ECC内存来保证超长时间的工作当中仍然稳定、高效,甚至需要做双机热备,一台挂掉另一台可以立即顶岗,对于一天开一次,晚上就关机的PC,乃至设计师朝九晚五用的工作站来说,有没有ECC其实都无所谓。另外,宕机引起的损失也是一个考虑。对于一家网站来说,服务器掉线意味着巨大的经济损失,因此绝对不可轻易宕机或者要求重启,而个人使用的电脑——只要做好数据备份,出了问题重启一下也不是什么大事。

在图形领域,OpenGL的完整支持一直是专业显卡的重要特性。但是,前面提出过一个问题——如果连专业软件都不再依赖于OpenGL了呢? 这样的事情已经发生了。Autodesk Nitrous已经标志着DirectX也开始入侵商用领域了。更让人默默捂脸无语的是,有一些软件厂商已经拿画面表现日趋逆天的游戏引擎,魔改出了完全基于GPU的“渲染器”。其中Lumion就是一个很有意思的代表。

这样的“渲染器”,恐怕非高端游戏卡不能胜任。如果要达到与之相类似的性能的专业显卡,价格恐怕得是游戏卡的十倍之多。

目前,专业显卡仍然有一些不可替代的优势,如完整的双精度浮点运算,不管是nVidia还是AMD,都对民用GPU的双精度浮点运算做出了限制,这主要是为了保证专业卡和GPU运算卡的销售。如果GeForce也能和Quadro那样双精度浮点运算贼6,那Quadro和Tesla都卖不出去了——顺便说一下,现在的“显卡”,随着GPU通用计算的不断普及,早已具备了超越“显卡”的功能,nVidia一直是深度学习的重要推手,其技术根源就是基于GPU通用计算的机器学习。

另外,专业显卡往往会狂堆GRAM。Quadro顶级产品线具备24GB的GRAM,而GeForce顶级产品线只有一半数量的12GB。这也是为了大规模建模和CG领域的超高精度贴图所作出的应对措施。游戏很少会吃掉这么多的显存。

从硬件角度来说,ECC支持与专业显卡应该是PC和工作站之间目前看来比较明显的区别了。除此之外,就是硬件冗余与可扩展性能。高端工作站可能会装备两个CPU插槽,16个DRAM插槽,另外,也有可能采用SCSI/SAS硬盘组建RAID,保证数据的安全——当然,随着现在PCI-E SSD的流行,SCSI/SAS在数据存取速度上已经完全吃瘪。但是,Intel仍然有推出企业级SSD产品,提供了比民用级SSD更高的可靠性,如在异常断电的时候,更多的电容可以让数据可以安全写回NAND而不会丢失。

所以,对于终端用户而言,如果只是早上开机,晚上关机,并不会整天整天地开着机满负荷跑渲染,其实一台性能不错的PC足以胜任一切工作。

但是在商用领域,能够以满负荷跑上半个月的工作站仍然有自己存在的必要。这就得说到目前工作站的优势,更多地并不体现在硬件方面,而是体现在软件方面。

除了设计上会祭出GPU的全部功能,厂商也会针对特定应用推出专用的驱动。nVidia Quadro就有专门针对AutoCAD和3Ds Max的性能驱动。这种点对点优化的待遇,GeForce是无福享受的。更重要的是,工作站有一个很重要的认证——ISV认证(Independent Software Vendors)。取得了软件的ISV认证,意味着以原厂配置运行特定的软件受到了软件厂商的认可,可以保证出问题的概率很低,出了问题他们也会承诺背锅。 另外,整机工作站亦会在出厂时接受严苛的测试,保证它可以在高负载长时间运行下不会挂掉。在整机设计的时候亦会考虑到这些问题。如风道的设计、电源、存储设备等零部件的可扩展性。一个很典型的例子就是工作站与PC的电源的设计是明显有很大区别的。

其实工作站的很多零部件都是采用的类似的模块化设计。比如存储设备:

所有的这些,让工作站拥有了PC远远达不到的可扩展性,而且近年来,工作站愈加将“Scalable”作为产品设计的主要卖点,并且强调“按用户需求”,提供最适合的企业级产品,如机架式工作站、刀片式工作站等等,以满足从终端的用户到大规模渲染农场的不同等级的性能需求。而当性能顶到一定程度之后,操作系统就该考虑换成商用系统了。Windows 7企业版最高可以支持到192G的系统,但是某些怪物工作站里面可以插1TB的内存、8个CPU(每个28核心56线程),这类工作站就得安装Linux或者Windows Server操作系统。

是的,工作站vs PC,在终端用户这个层面上,看起来现在PC已经占据了上风,尤其是性价比方面。然而其实没有。这里的差距并非Xeon E3 vsCore i7或者Quadro P6000 vs GeForce GTX Titan X那么简单直白的硬件性能的对比,而是在这硬件背后软实力的对比。无论如何,一个攒PC的玩家再有丰富的经验,也无法与凝聚了业内最顶尖大脑的一线厂商拼开发实力。一个攒机玩家懂得如何设置机箱风道,避免多个散热器之间气流的干扰就已经算得是很有经验的了,但是与那些CPU上连风冷都不压,直接上一排热管鳍片,然后靠整个机箱极为优异高效的气流来将机箱内所有的热量一起带走的这样的设计相比,就显得非常粗糙了。还有极为便利的全模块化设计,更不用提那些没日没夜的软件性能测试、兼容性测试、稳定性测试,这里所付出的一切都是普通用户和他们自己装的PC根本就做不到的。

是的,即便核动力大炮已经是我手上装出来的第11台PC,即便我给它的CPU和显卡都压上了水冷,即便我给它装了以高度稳定著称的Debian,我也不敢保证它可以在满负载的情况下运行一个星期。但是我却相信那台慢得让人脑袋嗡嗡作响、打开一个PPT花上两分钟的T5610可以。——其实最重要的是,我知道T5610出了问题,肯定会有人过来背锅,而自己的PC出了问题,就只能自己摸排了——而且这将会是一个极为痛苦的过程。核动力大炮坏过一次主板,这种痛苦只有经历的人才会懂。

幸运的是,业内良心企业Puget Systems很乐意将最新的硬件在不同的应用软件下的测试结果免费公开发布,作为想要自己攒一台工作机的用户的参考。这毫无疑问正在缩小自建PC与大厂工作站之间的差距。

回到最初的问题,我到底要不要一台工作站呢?

其实对于大多数只是业余拿机器来干一点零活的设计师来说,并不需要。稳定性要求并不是特别的高。至于那些花俏的专业显卡独有的功能,CADer可能用得上,而对于设计师来说,并不需要。毕竟设计师的主战场仍然在2D。无论如何,与VRED或者Octane相比,Photoshop都不能算一个很吃资源的软件吧。

也许Microsoft Surface Studio就不错呢?当然自己拼也是可行的了。

但是设计师也是有自己的要求的。设计师或许不需要强大的12核24核处理器,不需要专业显卡,但是有个东西是绝对逃不掉的——数位板。 我们下期再聊这个东西。